トラッキングは全3回の予定だったのですが、最後にARゴーグルのトラッキングについても軽く触れたいと思います。

はじめに

不思議ですよね。

VRヘッドセットとARゴーグルは、ディスプレイ方式に大きな違いがあるものの、できることは似かよってきていると思うんです。

VRヘッドセットは視覚全域をディスプレイが覆うので外界は直接見えないけれども、Video See-through によってAR的な使い方ができる。

ARゴーグルは Optical See-through の上にARコンテンツを重畳するけれども、ゴーグルにカバーをして外界を遮断すればVR的な使い方ができる(ただし現状FOVはVRヘッドセットに比べると半分程度だけれど)。

ARゴーグルは最初から歩き回ることが前提なのでスタンドアローン型、でもVRヘッドセットでもInside-Out方式によるスタンドアローン型が出てきています。

その割にこの価格差は何 ? というと、やはり最初に言ったディスプレイ方式が大きいのでしょうね。マイクロディスプレイ + Optical Waveguide のコストは確かに高そうです。

もう一つあげるとすれば、VRヘッドセットではセンサー類はカメラ + IMUとシンプルであるのに対し、ARゴーグルではこれらに加えて深度センサーが搭載されていることが多いこと、でしょうか。

ではデプスカメラがあればトラッキング精度は格段に良くなるのかしら、というところを少し深堀りして行きたいと思います。

HololensとMagic Leap One

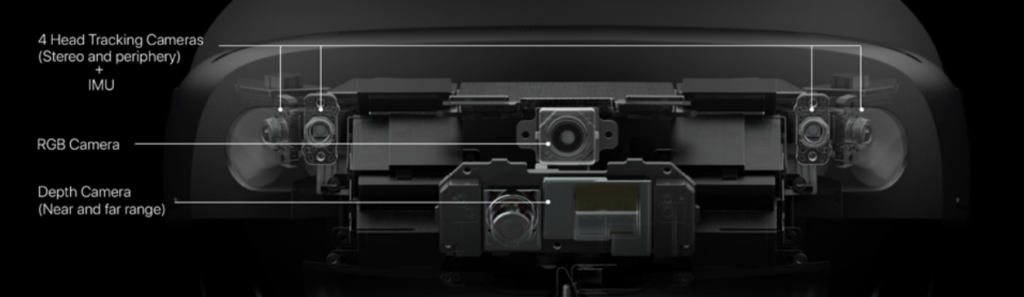

AR機器の中身については、VR・AR機器の構造 その4 – 実際のAR機器を見てみよう ! を参照してください。以下、センサー周りをまとめてみました。

初代Hololensは、IMU、環境認識 grayscale camera 4基、デプスカメラ1基、MRキャプチャー用RGBカメラ1基、照度センサー1基となっています。

Hololens 2も類似の構成ですが、IMU、環境認識 grayscale camera 4基、デプスカメラ (TOF sensor) 1基、MRキャプチャー用RGBカメラ1基です。

一方Magic Leap Oneは、IMU、環境認識カメラ4基、デプスカメラ1基という構成でした。

どれも概ね同じ構成ですね。これらのセンサーをどのように使っているのか、Hololens Research Mode のページによると、

- Visible Light Environment Tracking Cameras – Gray-scale cameras used by the system for head tracking and map building.

- Depth Camera – Operates in two modes:

- AHAT, high-frequency (45 FPS) near-depth sensing used for hand tracking. Differently from the first version short-throw mode, AHAT gives pseudo-depth with phase wrap beyond 1 meter.

- Long-throw, low-frequency (1-5 FPS) far-depth sensing used by Spatial Mapping.

- Two versions of the IR-reflectivity stream – Used by the HoloLens to compute depth. These images are illuminated by infrared and unaffected by ambient visible light.

- Accelerometer – Used by the system to determine linear acceleration along the X, Y, and Z axes and gravity.

- Gyro – Used by the system to determine rotations.

- Magnetometer – Used by the system to estimate absolute orientation.

と書かれていますので、

- ヘッドトラッキングは4基のグレースケールカメラ + IMUで主に行われている

- デプスカメラはふたつのモードを持ち、ハンドトラッキング用途と空間マッピング用途

- 地磁気センサーは絶対方位を推定するのに用いられている

となりますね。IR Strober があるので、4基のグレースケールカメラは赤外線カメラだと想像されますが、赤外光源をトラッキングするわけではないので、あえて可視光環境トラッキングカメラと謳っているのかも知れません。(赤外線カメラと言っても、普通のRGBカメラからIRフィルターを削除したものに過ぎませんが)

つまりハイエンドなARゴーグルのトラッキング方式は、恐らくInside-Out方式のVRヘッドセットのトラッキング方式とほぼ同じで、基本的にはARゴーグル上に搭載された環境認識カメラで外界を観測し、SLAMを用いて外界映像の動きからゴーグルの動きを逆算してトラッキングを行いますが、高速な頭の動きに追従するためにIMUも搭載され、センサーフュージョンデータをカルマンフィルターなどで処理することによって、最終的にゴーグルの位置と姿勢を推定しているわけです。また地磁気センサーも絶対方向を得るために補完的に用いられているようです。

つまりデプスカメラはあくまでも空間マッピング用途で、ARオブジェクトの正確な配置に用いられるということですね。もちろん頭を動かせば重畳するAR空間も回さないといけませんが、それはむしろ環境認識カメラ + IMUベースのヘッドトラッキング結果が基準になって、デプスカメラベースで認識した空間マップを回すような主従関係になっていると。そして200 msから1秒の周期でデプスカメラによる空間マップが更新されるようなシステム構成と考えられます。

そうだとすれば、デプスカメラなしでも VIVE SRWorks SDK のようにステレオカメラとAIによる空間マップ作成を行うことによって、もう少し安価なARゴーグルがあってもよいのではと思うわけですが、そのあたりに切り込んできたのがNrealLightです。

XrealLight

NrealLight あらため XrealLightです。ARグラスと言える形状ですが、センサー構成はとてもシンプルです。

両側2基のカメラはSLAM用のモノクロームカメラ、中央の1基は撮影やハンドトラッキング用のRGBカメラという構成です。もう1基見えるのはIR stroberかも知れません。

デプスカメラを搭載していないので正確な空間形状把握はできないとのことですが、SLAMはそもそも環境の3次元再構成を行う技術ですから、精度の問題はあるかも知れませんが、ある程度の空間マッピングは可能でしょう。

またAIを用いたセグメンテーション技術もかなりのレベルに達している(ex. Detectron2)ので、融合することによりいい線行くのではないでしょうか。コンシューマー機器としての可能性を感じますね。

VR・AR機器の構造 その4 – 実際のAR機器を見てみよう ! でもXrealLightについて触れているので、是非参照ください。

おわりに

今回はARゴーグルのトラッキング方式について触れてみました。

結果から言うとInside-Out方式のVRヘッドセットと同等のトラッキング技術でしたが、デプスカメラの用途も明確になって、かなりスッキリしましたね。

また、デプスカメラを搭載しない安価なARグラスも登場し、民生機器としての未来を感じることができました。

ということで全4回のトラッキングの講義はいかがでしたか ? 少しでもかゆいところに手が届いたらうれしいです。