VR・AR機器の構造について、実際の機器の中身を見ながら理解を深めていきたいと思いますが、第3回の今回は、Video See-through, Optical See-through, HOE Combiner, Optical Waveguide Combinerと言った着目ポイントを押さえていきます。

はじめに

VR・AR機器の構造について、実際の機器の中身を見ながら理解を深めていきたいと思いますが、AR機器の詳細に入る前に、まずAR機器の着目ポイントを押さえておきましょう。

ここでは以下に注目していきます :

- Video See-through

- Optical See-through

- HOE Combiner

- Optical Waveguide Combiner

それでは基本事項の詳細に入っていきます。

押さえておきたいAR機器の基本事項

Video See-through

ビデオシースルー方式は、HMDの前面に装着されたカメラで撮影した前方環境映像をディスプレイに表示して、リアルタイムの現実世界を提示する方式です。赤外カメラの場合と可視光カメラの場合がありますが、トラッキング方式とも直結するケースが多いですね。カメラ映像にCG (Computer Graphics) 映像を重畳することによって、AR的な視覚情報提示が可能になります。

ビデオシースルー表示の例としては、こちらのHTC ViveやOculus Questの動画がわかりやすいです。

ガーディアンとかシャペロンというのは、安全なVRの試遊のためにユーザーがプレイエリアを指定できるしくみです。VRは全視覚情報がバーチャルな世界に奪われるので、気がつかないうちに現実世界で障害物に近づいてしまうこともままあるわけですが、たとえばゲームプレイしていてガーディアンに近づくと外界表示になるなど、安全への工夫も進んでいます。

ビデオシースルー方式は、カメラ越しに現実世界をディスプレイに表示するので、あまり複雑なCG描画を行うと演算負荷による遅延(レイテンシー)が大きくなる懸念があります。また、奥行き計測もHMD上のカメラによるものなので精度懸念もあり、比較的シンプルな画像重畳がメインのユースケースというのが従来の印象でした。

しかし、VIVE SRWorks SDKのOverviewを見ると、メッシュがきれいに描けていたり、フロアーや平面認識も比較的正確にできているように見受けられます。ステレオマッチングやSLAMだけで(つまりデプスカメラなしで)ここまで正確にできるものかと目を疑いました。(AIベースのSemantic Segmentation的なものが動いているのではと予想)

ボールを投げるビデオを見ると、さすがに手の動きの映像とWand controllerのCG画像の間にもレイテンシーを確認できますし、対現実世界という意味ではさらにレイテンシーはかさむはずですが、結構複雑なAR表現がリアルタイムに可能になっていると感心しました。

Optical See-through

一方オプティカルシースルー方式は、HMD前面がたとえばハーフミラー状の構造になっていて、実際の外界が光学的に見える方式です。(詳細は後述)目の前の半透明のバイザー部分にマイクロディスプレイ映像を投影することによって、外界にCG映像を重畳し、ARを実現します。

オプティカルシースルー表示の例としては、こちらのMicrosoft HololensのSpatial Mapping動画やMagic Leap OneのWorld Reconstruction feature動画あたりが面白いでしょうか。

両機種とも比較的高価ということもあり、複数のデプスカメラを含む多数の環境認識用カメラが搭載されています。デプスカメラがあれば形状認識はお手の物ですし、フロアーやテーブルなど実物体形状に即したCG物体の重畳が可能です。ただし、FOV(視野角:Field of View)はVR機器に比べると半分程度が現状です。

実は上記の動画も、搭載されているRGBカメラの映像に重畳映像を上書きしたものですので、実際にユーザーが体験している視覚情報とは(とても似ていますが)厳密には違うものになります。特に明るい場所では重畳映像が薄くなってしまうので、ARオブジェクトのくっきり感はかなり違う場合があります。

HOE Combiner

次にコンバイナーです。現実世界にARオブジェクトを重ね書きして融合するので、Combinerです。

さきほどオプティカルシースルーのところで、HMD前面がたとえばハーフミラー状の構造になっていて、実際の外界が光学的に見える方式と説明しましたが、そのハーフミラー部分のことを言います。

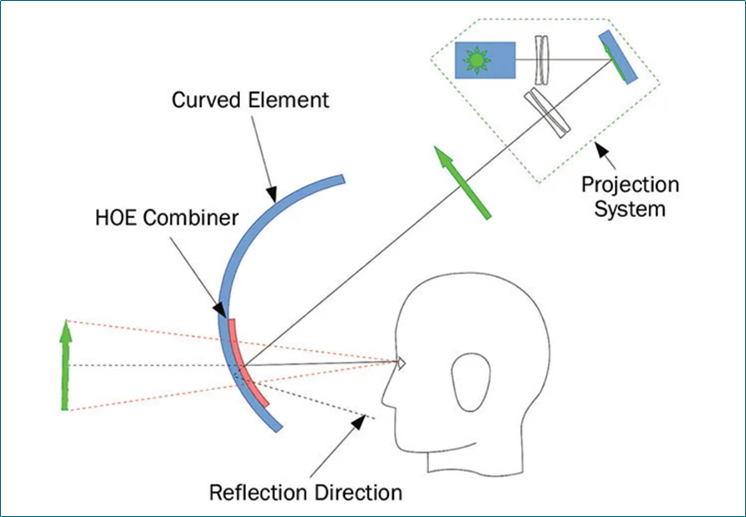

HOE (Holographic Optical Element) はホログラフィック光学素子で、特定波長の光の屈折や反射、反射角を制御できるプラスティックフィルムのことです。HOEをコンバイナーとして用いたシンプルな投影方式は、バイザー前面の曲面ホログラムハーフミラーにマイクロディスプレイの画像を投影するDirect Reflection方式です。(なので形状からすると、Direct Reflection Combinerと言った方がよいのかも知れません)

この論文(Holographic Combiners Improve Head-Up Displays)はとてもわかりやすいですので、是非目を通してみてください。

この方式を搭載した代表的な機器として、Meta2があります。(Meta 2|没入型AR体験ヘッドセット「メタ2」)アイキャッチ画像や動画を見てもわかるとおり、額の前あたりにプロジェクションシステムがあり、大きくせり出したバイザー曲面に反射させて提示画像を重畳します。直接反射を利用するためどうしても大きく前にせり出したコンバイナーが必要になりますが、投影経路に制限が少ないのでFOVを確保しやすいという利点があります。実際90度のFOVはAR機器としてはとても広いですね。

Optical Waveguide Combiner

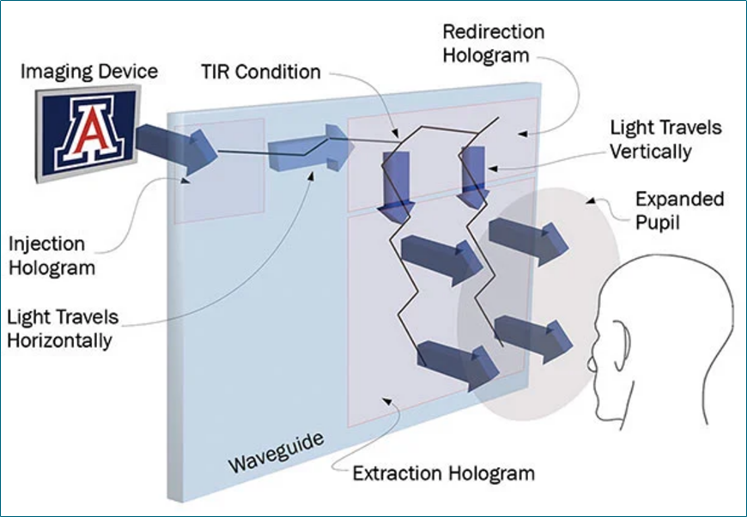

一方オプティカルウェイブガイドを用いる方式では、光導波路によってマイクロディスプレイ画像を目の前にまで持ってきてホログラフィック回折格子(グレーティングとも言います)により射出投影する方式です。

光導波路部分はTotal internal reflectionのFig. 2のように、光が全反射を繰り返して移動します。あとは光導波路への光の入射と射出ができればよいわけですが、それを実現するのがホログラフィック回折格子部分になります。顕微鏡写真がSecrets of HoloLens optics revealedにあります。

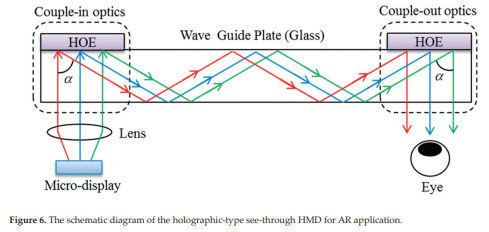

Waveguide-Type Head-Mounted Display System for AR ApplicationのFigure 6を見ると、その全体像がよくわかると思います。光導波路への入射と射出の2か所にHOEがあり、そこで光を屈折反射させることにより、マイクロディスプレイからの光を導波路内へ導いたり、導波路から目へ光を射出します。

Direct Reflection方式と比べてバイザーの薄型化に大きく貢献する技術ですが、1995年のNokiaの特許がベースになっています。

実際にはAR映像は平面情報ですので、先ほどの論文(Holographic Combiners Improve Head-Up Displays)のFigure 5にあるように、2段階の拡大(2D expansion) を経て目に届きます。拡大というのは、グレーティングエリアを広く確保して重畳映像が見える範囲(Eye Boxと言います)を広げることを指します。ただしあまり広げすぎると光の強さが薄まってしまいますので、デザインバランスが重要な部分になります。

このあたりは考え始めると謎が深まるばかりになります(実際にはグレーティングの深さや角度が場所によって変化していてうまくEye Boxが構成されるようになっている)ので、

- 離れた場所にあるマイクロディスプレイ映像を目の前まで持ってくるために、光導波路を利用する

- 光導波路へのディスプレイ映像の導入と目への射出には、HOEグレーティングによる屈折反射が用いられる

この2点を押さえておきましょう。

この方式を搭載した代表的な機器として、HololensシリーズやMagic Leapシリーズがあります。これらの機器の構造については次回深堀りする予定ですが、以下の記事がわかりやすくて面白いです。

たとえばHololensだと、やはり額の前あたりにプロジェクションシステムがあり、そこからウェイブガイドにより水平方向に広げたあと垂直方向に広げて映像が見える位置の範囲を広げます。バイザーの薄型化に寄与しますが、FOVやコントラストの確保が課題です。

ということで、ARゴーグルの代表的な光学系についてざっと説明しましたが、マイクロディスプレイって何だろう ? って思いますよね。最後に軽く説明したいと思います。

プロジェクターの種類としくみ

やはり絵がないとわかりにくいですよね !? プロジェクターのLCDとかLCOSとかDLPって何?にとてもわかりやすい絵が図示されていますので、是非参照してください。では簡単に説明します。

プロジェクターはパワポとかをスクリーンにプロジェクションするのに使用しますが、主に3タイプあります。

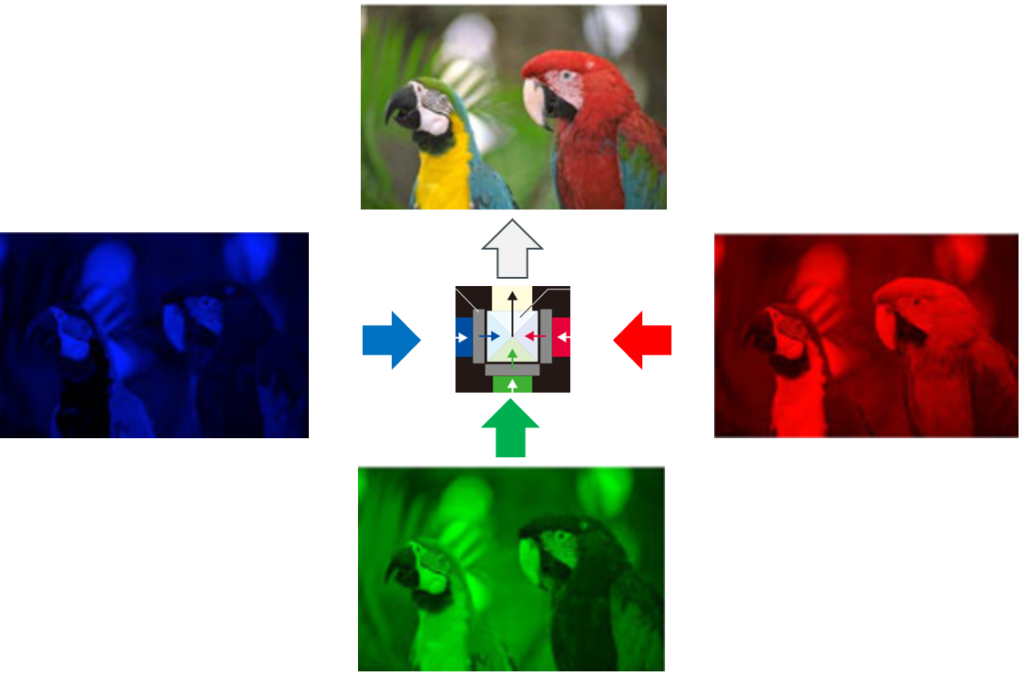

一般的なものがLCDという透過型液晶ディスプレイです。光を透過させたときに例えば8ビット階調でドット単位に透過したり透過させなかったり制御できるものです。これをRGBそれぞれ行いプリズムで屈折合成して投影します。

一方LCOSという反射型液晶ディスプレイは光を当てるとドット単位に反射したりさせなかったり制御できるものです。これをRGBそれぞれ行いプリズムで屈折合成して投影します。HololensやMagic LeapシリーズではLCOSのマイクロディスプレイが採用されています。

もう一つあるのがDLPという方式で、これはDMDというデジタルマイクロミラーアレーデバイスでピクセル毎に反射制御します。ON/OFFの切り替えが高速に行えるため、RGBを時分割で制御し、さらに階調表現もONの時間で制御します。

おわりに

ということで、今回はAR機器の構造の着目ポイントを押さえてみました。

VR機器に用いられるビデオシースルーだと、やはりレイテンシーに起因する酔い問題が気になるところです。一方オプティカルシースルーではハーフミラー越しに本当の現実世界が見えていますので、酔い問題への懸念は少ないと言えます。

またコンバイナーやオプティカルウェイブガイド部分は最先端の光学系が詰まってますね。

第1回と今回ご紹介したポイントをベースに、次回は実際のAR機器の中身を見ながら理解を深めていきましょう。機器の中身は、 iFixitのTeardownサイトとKGOnTechで確認していきます。

それではまたお会いしましょう。